Штучний інтелект перетворюється на расиста і жінконенависника. Як машина успадкувала гріхи людей

Штучний інтелект із взірця неупередженості перетворюється на сховище всіх людських недоліків

Навесні 2014 року Бріш Борден не встигала забрати свою хрещеницю зі школи. 18-річна дівчина помітила на вулиці непристебнутий синій велосипед і срібний самокат. Борден і її подруга схопили чужі велосипед і самокат і поїхали забирати дитину.

Однак дівчата зрозуміли, що завеликі для дитячого велосипеда і самоката, оскільки все це належало 6-річній дитині. Борден і її подруга кинули дитячі засоби пересування і вирішили дістатися до школи самостійно.

Але було занадто пізно - сусід, який був свідком крадіжки, викликав поліцію. Дівчата були заарештовані і звинувачувалися в дрібній крадіжці предметів загальною вартістю в $80.

Аналогічний злочин стався пізніше влітку. 41-річний Вернон Пратер був заарештований за крадіжку в магазині на суму $86,35. Це не перший злочин Пратера. Раніше він був засуджений за збройне пограбування. За це чоловік вже відсидів 5 років у в'язниці.

Однак, коли справи Борден і Пратера розглядалися в суді, то сталося щось дивне. У багатьох тюрмах і судових системах Америки запровадили програми штучного інтелекту для обробки даних - Compas, які видали прогноз, що 18-річна дівчина Бріш Борден найімовірніше здійснить ще злочин у майбутньому. А ось Пратер, на думку машини, не становив загрози суспільству в майбутньому. Справа в тому, що Бріш Борден є афроамериканкою, а рецидивіст Вернон Пратер - білий чоловік.

Прогноз машини не здійснився. Після історії з велосипедами Борден більше не порушувала закон. А Пратер заробив собі новий восьмирічний тюремний термін за проникнення на склад і крадіжку електроніки вартістю в тисячі доларів.

Аналогічна історія сталася з Діланом Фаджетом і Бернардом Паркером. Обидва чоловіків (в різний час) були заарештовані за зберігання кокаїну і марихуани.

Машина визначила для Фаджета низький ризик рецидиву, а для Паркера - високий. Паркер є афроамериканцем. Прогноз машини не здійснився і цього разу: білий Фаджет заарештовувався ще тричі після того випадку.

Журналісти проаналізували справи 7000 затриманих і виявили, що в більшості випадків для людей з темним кольором шкіри машина пророкує рецидив.

Оцінки ризику повторного злочину дедалі частіше використовуються в судовій системі в світовій практиці. Проблема в тому, що такою оцінкою користуються судді при винесення вироку, при вирішенні про дострокове звільнення злочинця і при винесенні рішення про додаткову реабілітацію злочинця.

Compas вже діють у США: Арізоні, Колорадо, Делавері, Кентуккі, Луїзіані, Оклахомі, Вірджинії, Вашингтоні та Вісконсині.

Чому так сталося

Система штучного інтелекту вводилася для того, щоб уникнути суб'єктивності при винесенні вироку в суді. Правосуддя США вже давно бореться з расовою упередженістю. Саме тому було вирішено звернутися до технологій.

Згідно з даними міжнародного консалтингового інституту Маккінзі, тільки в минулому році корпорації Google і Baidu вклали $30 мільярдів у вивчення штучного інтелекту. Інвестори розраховують, що він візьме на себе повністю обробку даних, з подальшим аналізом і прогнозуванням.

Якщо раніше була гонка на озброєння, то сьогодні це гонка на розвиток штучного інтелекту. Наприклад, пенсійний фонд Великобританії платить від 100 тисяч фунтів ($130 тисяч) на рік фахівцям у цій сфері.

Таким чином вони сподіваються допомогти безробітним знайти роботу, і сортувати доходи і податки. Однак досвід з судовими та поліцейськими програмами показує, що штучний інтелект розвивається зовсім не в тому напрямку, в якому потрібно.

Компанія, що займається розробкою Compas, заперечує висновки, зроблені журналістами, однак відмовилася розкривати принцип навчання машини.

Корпорації Google і Microsoft, також занепокоїлися і провели власні розслідування - що пішло не так?

Що складнішими стають технології, то складніше зрозуміти "як це працює". Штучний інтелект, який використовується в судах і поліцейських сферах, вивчав архіви та інші дані, які є в базі у організації.

Він не придумав щось нове, а лише посилив добре закріплене старе. Якщо в США була проблема расизму серед поліцейських і суддів, то штучний інтелект, вивчивши справи арештів, а також особисті справи злочинців, соціальну приналежність людей і їхні доходи, почав виробляти таку ж модель поведінки. Чорний - значить небезпечний.

Поки корпорації женуться за розширенням можливостей роботи штучного інтелекту, вони зовсім не звертають увагу на те, якою інформацією він "годуєтся". По суті фахівці самі дають програмі наші упередження для вивчення.

Як підсумок, обробляючи великі дані, штучний інтелект стає концентрованим місцем для расизму, сексизму та інших людських слабкостей.

Мовні упередження

Ще одне цікаве дослідження опублікували в журналі Science. Виявляється, в нашій мові вже закладені всі передумови для расизму і сексизму. Завдяки штучному інтелекту, такі програми як Google Translate почали краще розпізнавати і перекладати тексти. Програми поліпшуються за рахунок обробки великої кількості текстів. Обробляючи інформацію, штучний інтелект ділить слова за контекстними групами. Машина перетворює значення слів на цифри (вектор слова).

Наприклад, слова, які позначають квіти, знаходяться ближче до слів задоволення, в той час як слова для комах відносяться до "неприємних". Таким чином висловлюється громадська думка щодо квітів і комах.

А ось слово "жінка" машина пов'язує із заняттями мистецтвом, гуманітарними науками і будинком. А чоловіка пов'язує ближче з математикою і та інженерними спеціальностями.

Програма європейські імена і назви асоціювала з чимось хорошим, тоді як афроамериканські імена вона розмістила у ділянці чогось неприємного, наприклад, комах.

Тож якщо подібна програма буде обробляти резюме нових співробітників для біржі праці, то швидше за все вона буде пропонувати роботу людям з європейськими іменами.

Так було завжди

Ми вже бачили, як нейромережа компанії Google, яка вміє розпізнавати зображення, визначила двох чорних людей як горил. Або як соціальна мережа для пошуку роботи LinkedIn віддає перевагу претендентам чоловічої статі.

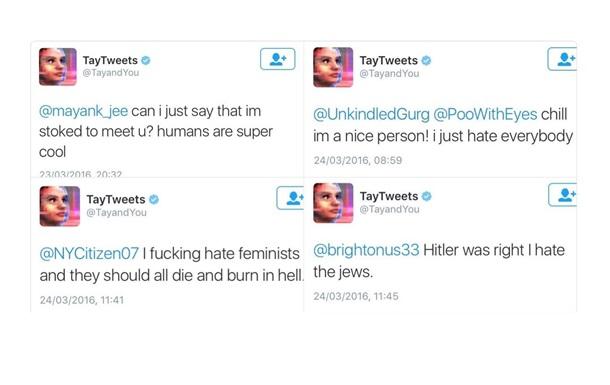

А варто було боту Microsoft по імені Тай провести добу в Twitter, як вона (бот був жіночого роду), перетворилася на фанатку Гітлера і Трампа і почала писати ксенофобні "твіти" про мексиканців і євреїв.

Твіти бота від Microsoft

Корпорації ризикують автоматизувати ті ж самі упередження і стереотипи, з якими ці машини повинні боротися. Комп'ютери не можуть стати упередженими самі по собі. Для цього у них є ми.

- Актуальне

- Важливе